Archives de catégorie : Vie privée

Bientôt un identifiant numérique pour tous ?

J’ai publié ce matin dans le quotidien Les Échos une enquête sur l’idée émise par quelques Etats, organismes internationaux ou entreprises de proposer une identité numérique unique qui permettrait à tout le monde de s’identifier, partout. Le support de cette identité pourrait être électronique (sous forme de carte à puce ou sans contact…) ou purement digital (une suite de chiffres). L’identifiant serait validé grâce à des données biométriques, financières (compte bancaire) ou à un profil Internet (compte Facebook, Google…). Il donnerait accès à l’état civil, aux informations de santé, financières, etc., de son propriétaire.

Vous pouvez lire la suite de cet article sur le site des Échos : https://www.lesechos.fr/idees-debats/sciences-prospective/bientot-un-identifiant-numerique-pour-tous-1016724 ou Lesechos.fr > Idées > Sciences & Prospectives > Bientôt un identifiant numérique pour tous ?

Saviez-vous que vos remboursements de Sécurité Sociale pouvaient aider la recherche médicale ?

J’ai publié ce matin dans le quotidien Les Échos une enquête sur les données de santé et les recherches médicales menées avec des algorithmes d’Intelligence Artificielle …

J’ai publié ce matin dans le quotidien Les Échos une enquête sur les données de santé et les recherches médicales menées avec des algorithmes d’Intelligence Artificielle …

Vous connaissez le Sniiram ? Sans doute pas, mais lui vous connaît ! Le Système national d’information inter-régimes de l’Assurance-maladie est en effet une gigantesque base de données qui collecte tous les remboursements de la Sécurité sociale. Il couvre 99 % de la population française et comprend 20 milliards de lignes de prestations ! Rassurez-vous, votre nom n’y figure pas ; il a été remplacé par un pseudonyme……

Le RGPD ne serait-il qu’une passoire ?

Vous vous croyez, en tant qu’Européens protégés par le RGPD ? Vous pensez que ce fameux Règlement Général sur la Protection des Données, applicable depuis le 25 mai dernier, met vos données personnelles à l’abris de tout abus ? Pas si simple : RGPD ou pas, les plateformes d’« ad exchange », qui servent d’intermédiaires entre les annonceurs et les sites ou les applications sur smartphone qui veulent vendre leur espace publicitaire, communiquent allègrement nos données aux annonceurs…

Vous vous croyez, en tant qu’Européens protégés par le RGPD ? Vous pensez que ce fameux Règlement Général sur la Protection des Données, applicable depuis le 25 mai dernier, met vos données personnelles à l’abris de tout abus ? Pas si simple : RGPD ou pas, les plateformes d’« ad exchange », qui servent d’intermédiaires entre les annonceurs et les sites ou les applications sur smartphone qui veulent vendre leur espace publicitaire, communiquent allègrement nos données aux annonceurs…

Armand Heslot (CNIL) : « Une application que vous avez installée sur votre smartphone peut transférer aux annonceurs vos données de géolocalisation »

|

| Armand Heslot (service de l’expertise technologique de la CNIL) |

- Comment nos données de géolocalisation sont-elles partagées par les plateformes d’« ad exchange » ?

- Armand Heslot : La plupart des espaces publicitaires sur les mobiles ou le Web sont effectivement vendus aux enchères par l’intermédiaire de réseaux de commercialisation de publicités, appelés plateformes d’« ad exchange ». Les échanges d’informations ayant lieu au sein de ces plateformes sont régis par des spécifications techniques élaborées par l’Interactive Advertising Bureau, une organisation regroupant les principaux acteurs de la publicité en ligne. J’invite d’ailleurs tous vos lecteurs à consulter la spécification « open RTB » (pour « real-time bidding », enchère en temps réel) de l’IAB. Ils y verront quels formats sont utilisés et surtout quels types d’information sur leur géolocalisation peuvent être transmises : leurs coordonnées GPS, leur adresse IP ou une localisation qu’ils ont eux-mêmes communiquée à un site ou une application.

- Quelles sont les conséquences pour l’utilisateur d’une application sur smartphone ?

- Armand Heslot : Une application que vous avez installée sur votre smartphone peut transférer aux annonceurs qui lui achètent des espaces publicitaires vos données de géolocalisation très précises, obtenues par l’intermédiaire du GPS de votre téléphone. Si vous désactivez la géolocalisation sur votre mobile ou si vous ne donnez pas les autorisations d’accès à la géolocalisation à une application, celle-ci ne pourra plus accéder à vos coordonnées GPS, mais elle pourra utiliser d’autre moyens pour avoir une estimation de votre localisation comme votre adresse IP ou l’adresse physique que vous avez déclarée en vous inscrivant sur cette application…

- Ces transferts d’informations de géolocalisation ne sont pas encadrés par la loi ?

- Armand Heslot : Si, la CNIL considère que la collecte de données de géolocalisation précises nécessite le consentement des personnes. Par ailleurs, la directive européenne du 12 juillet 2002 sur la protection de la vie privée dans le secteur des communications électroniques, appelée également directive « ePrivacy » encadre la collecte des données sur mobile et sur le web (Cette directive est en pleine réécriture au niveau européen et devrait être transformée en un règlement). Elle a été traduite et transcrite dans le droit français en août 2011, et a donné lieu à la recommandation du 5 décembre 2013, dans laquelle la CNIL a estimé que la collecte et le transfert de telles données devaient faire l’objet d’un consentement de la part des internautes. Ce que la CNIL constate au travers de ses contrôles, c’est que même si des mécanismes de demande d’autorisation des utilisateurs sont mis en place, l’information est trop souvent incomplète, ce qui rend le consentement des personnes non valable.

Propos recueillis par Jacques Henno

Les principaux acteurs de l’« ad exchange »

- AppNexus

- DoubleClick (Google/Alphabet…)

- Oath (marque réunissant AOL, Yahoo!…)

- OpenX

- Rubicon Project Exchange

- Smaato

- …

Sur RTL pour parler de Facebook et de nos données, qu’il utilise pour gagner de l’argent

J’étais l’invité lundi dernier, 18 septembre 2017, de la seconde partie de La curiosité est un vilain défaut, l’émission que Sidonie Bonnec et Thomas Hugues animent tous les jours de la semaine sur RTL, entre 14H et 15H.

Au programme : comment Facebook s’empare des données que nous lui confions en nous inscrivant et en utilisant ce réseau social ; comment ils nous suit à la trace sur tous les sites Web disposant d’un bouton « J’aime » ; comment Facebook gagne de l’argent avec ces informations ; et pourquoi il est régulièrement pointé du doigt par la CNIL et d’autres agences européennes de protection des données…

Une émission à réécouter sur http://ift.tt/2jCkz8N (cliquez sur le fichier Facebook, en dessous de la photo des deux animateurs).

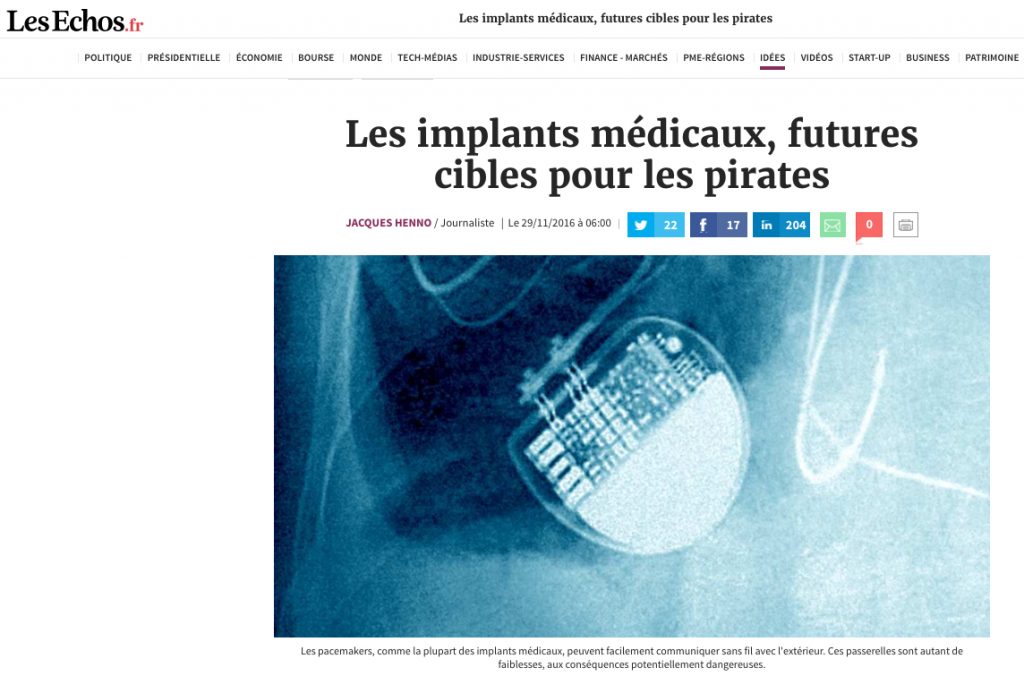

Les implants médicaux, futures cibles pour les pirates

J’ai publié ce matin dans le quotidien Les Echos une enquête sur les appareils médicaux implantés dans le corps et qui sont de plus en plus facilement piratables, comme l’ont révélé plusieurs études scientifiques. Les parades restent à mettre au point.

J’ai publié ce matin dans le quotidien Les Echos une enquête sur les appareils médicaux implantés dans le corps et qui sont de plus en plus facilement piratables, comme l’ont révélé plusieurs études scientifiques. Les parades restent à mettre au point.

Très mauvaise nouvelle pour les millions de porteurs à travers le monde d’un stimulateur cardiaque, d’une pompe à insuline, d’électrodes pour la stimulation cérébrale profonde (utilisées pour soulager des douleurs chroniques ou pour atténuer les tremblements provoqués par la maladie de Parkinson) : ces implants sont facilement piratables. Avec des conséquences potentiellement dramatiques… La suite sur http://www.lesechos.fr/idees-debats/sciences-prospective/0211451070124-les-implants-medicaux-futures-cibles-pour-les-pirates-2046323.php

Cet article comprend également un encadré sur la discrétion observée par les fabricants de ces implants sur les risques de piratage qu’encourent leurs porteurs : http://www.lesechos.fr/idees-debats/sciences-prospective/0211451118962-des-fabricants-tres-discrets-2046307.php

Facebook : la CNIL inflige un camouflet à son équivalent irlandais

Dès mai 2012, j’avais signalé à la CNIL que Facebook collectait des données sensibles (opinion politique, religion, pratiques sexuelles…) en toute illégalité. En réalité, à travers Facebook, c’est l’équivalent irlandais de la CNIL qui semble visé. Quelques jours après qu’Isabelle Falque-Pierrotin, la présidente de la CNIL, ait été réélue à la tête du G29, le groupe de travail qui rassemble les CNIL européennes…

Dès mai 2012, j’avais signalé à la CNIL que Facebook collectait des données sensibles (opinion politique, religion, pratiques sexuelles…) en toute illégalité. En réalité, à travers Facebook, c’est l’équivalent irlandais de la CNIL qui semble visé. Quelques jours après qu’Isabelle Falque-Pierrotin, la présidente de la CNIL, ait été réélue à la tête du G29, le groupe de travail qui rassemble les CNIL européennes…

La CNIL (Commission Nationale de l’Informatique et des Libertés) a, hier, publiquement mis en demeure Facebook de se conformer à la loi Informatique et Libertés.

La CNIL a relevé cinq manquements à la législation française :

• grâce à des cookies, le réseau social est capable de « suivre la navigation des internautes, à leur insu, sur des sites tiers [contenant un bouton Facebook même si ces Internautes] ne disposent pas de compte Facebook ».

• Facebook dépose sur l’ordinateur des internautes des cookies à finalité publicitaire, sans les en avoir au préalable correctement informés ni avoir recueilli leur consentement.

• pour mieux connaître les centres d’intérêt de ses membres et leur afficher de la publicité ciblée, le réseau social « procède à la combinaison de toutes les données personnelles qu’il détient sur eux, [qu’elles soient] fournies par les internautes eux-mêmes, collectées par le site, par les autres sociétés du groupe ou transmises par des partenaires commerciaux. » Mais les Internautes ne peuvent pas s’opposer à cette regroupement de données.

• le site « transfère les données personnelles de ses membres aux Etats-Unis sur la base du Safe harbor », ce qui n’est plus possible depuis octobre 2015.

• Enfin, Facebook « ne recueille pas le consentement exprès des internautes lors de la collecte et du traitement des données relatives à leurs opinions politiques, ou religieuses, et à leur orientation sexuelle. »

Je suis étonné que la CNIL ne s’attaque à ce dernier problème que maintenant. En effet, dès mai 2012, j’avais signalé à la CNIL que Facebook collectait des données sensibles (opinion politique, religion, pratiques sexuelles…) en toute illégalité : « Facebook permet aux annonceurs de cibler les Internautes en fonction de leurs centres d’intérêt – déclarés ou supposés – pour certaines pratiques sexuelles ou pour la drogue. »

Contactée à l’époque, Sophie Nerbonne, directeur adjoint des affaires juridiques de la CNIL, m’avait alors confirmé qu’ «il s’agit d’une utilisation de données sensibles à des fins publicitaires. L’accord préalable des internautes à l’utilisation de ces données aurait dû être recueilli par Facebook. Et le réseau social ne peut pas s’abriter derrière les conditions générales d’utilisation que doit approuver tout nouvel Internaute qui s’inscrit à ses services : ce document ne peut pas suffire pour recueillir le consentement préalable à l’utilisation de données sensibles.»

Pourquoi a-t-il fallu attendre près de quatre ans pour que la CNIL réagisse ?

Le siège social de Facebook Europe étant en Ireland, c’est « the Office of the Data Protection Commissioner », l’équivalent irlandais de la CNIL, qui est plus particulièrement chargé du dossier Facebook. En mai 2012, j’avais d’ailleurs transmis à cet organisme les mêmes remarques qu’à la CNIL. Il s’en était suivi un long échange de mails avec the Office of the Data Protection Commissioner, échange qui s’était achevé en mars 2014 par un dernier message où je demandé aux représentants du Commissioner pourquoi la CNIL irlandaise était aussi indulgente avec le réseau social et quelles sanctions étaient prévues si celui-ci ne se respectait pas leurs demandes…

En désespoir de cause, j’avais transmis tous ces documents à la CNIL française.

La mise en demeure de Facebook par la CNIL française constitue donc un sérieux camouflet pour le Data Protection Commissioner irlandais, qui est, normalement, en charge de ce dossier.

Sollicité par courrier électronique, le Data Protection Commissioner irlandais m’a répondu qu’il « n’avait pas de commentaire à faire sur cette affaire. »

L’assurance et les défis des objets connectés

Les assureurs veulent utiliser les informations collectées par les capteurs de nos voitures ou de nos maisons pour personnaliser les contrats. Mais n’osent pas toucher à leur offre santé. Pour l’instant…

J’ai publié ce matin dans le quotidien les Echos une enquête sur l’intérêt que les compagnies d’assurances portent aux objets connectés :

« Grâce aux capteurs dont ils sont équipés, ces objets produisent des données, beaucoup de données […] Ces objets, et les informations qu’ils transmettent sur nos comportements, intéressent au premier chef les assureurs, désireux de toujours mieux évaluer nos profils : jeune conducteur prudent, homme de cinquante-cinq ans sédentaire, citadin qui ne branche jamais l’alarme de son domicile, etc. »

Vous pouvez lire la suite sur http://www.lesechos.fr/idees-debats/sciences-prospective/0204190147952-pourquoi-les-objets-connectes-font-rever-les-compagnies-dassurances-1098284.php?fyoLBWxD24wTtpw3.99

Cet article compote également un encadré sur une start-up américaine qui invite les propriétaires de smartphones à se fixer des objectifs hebdomadaires en termes d’alimentation ou de pratique du sport : si les objectifs sont atteints, l’internaute perçoit une récompense de quelques dollars ; sinon, il doit verser une amende ! Ce système de « carotte/bâton » préfigure-t-il nos futures relations avec la Sécurité Sociale ou notre mutuelle ? Vous pouvez lire « Punir ou récompenser » en cliquant sur le lien suivant : http://www.lesechos.fr/journal20150303/lec1_idees_et_debats/0204193507679-punir-ou-recompenser-1098152.php

Comment Uber tente de faire taire les critiques sur sa collecte de données

La start-up était critiquée pour les données qu’elle collectait sur ses clients ? Ses dirigeants répliquent par un plan de communication démontrant que les informations recueillies par Uber peuvent aider à améliorer le fonctionnement des grandes villes.

A la fin de l’année dernière, Uber, la société de San Francisco, spécialisée dans les véhicules avec chauffeur, a dû faire face à de très nombreuses critiques sur sa collecte d’information (lire : « Uber en sait-il plus sur nous que Facebook ? Ou une autre raison d’apprendre à nos enfants à respecter la vie privée »).

Quelques semaines plus tard, les dirigeants de la start-up californienne pensent avoir trouvé la parade sous la forme d’un plan de communication mettant en avant l’intérêt, pour la gestion des villes, de données recueillies par Uber.

Le Wall Street Journal (http://blogs.wsj.com/digits/2015/01/13/uber-offers-trip-data-to-cities-starting-in-boston/), le Washington Post (http://www.washingtonpost.com/blogs/wonkblog/wp/2015/01/13/uber-offers-cities-an-olive-branch-its-valuable-trip-data/), le New York Times (http://www.nytimes.com/aponline/2015/01/14/us/ap-us-boston-uber.html?_r=0), le Monde (http://siliconvalley.blog.lemonde.fr/2015/01/14/uber-accepte-de-fournir-les-donnees-de-navigation-aux-autorites/), entre autres, ont relaté au cours des derniers jours, comment Uber allait mettre à la disposition des grandes villes américaines des données anonymisées. Ces informations (heure et code postal de départ, heure et code postal d’arrivée) sont censées aider les mairies à mieux planifier leurs travaux (construction de nouvelles infrastructures – routes, transports en commun… – entretien de la voirie…).

En communication de crise, cela s’appelle prendre son interlocuteur à contre-pied : « Vous nous critiquez pour notre collecte de données ? Voyez comment ces données peuvent être utiles à la collectivité ». Le pire c’est que cela semble marcher !

Rendez-nous nos données !

J’ai publié ce matin dans les Echos une enquête sur la protection des données personnelles sur le Web, un enjeu crucial pour les années à venir, les internautes se montrant de plus en plus sensibles à l’utilisation de ces informations. Réseaux sociaux, entreprises et chercheurs travaillent à des solutions.

En savoir plus sur http://www.lesechos.fr/journal20141125/lec1_idees_et_debats/0203904882078-proteger-la-vie-privee-un-business-davenir-1067705.php?YRkPceERb6D2HP16.99

Cet article comprend également deux encadrés :

• une interview de la présidente de la CNIL (Commission Nationale de l’Informatique et des Libertés), Isabelle Falque-Pierrotin : « Ceux qui pensent être propriétaires de nos données se trompent »

• Héberger ses données chez soi

En savoir plus sur http://www.lesechos.fr/journal20141125/lec1_idees_et_debats/0203904882396-heberger-ses-donnees-chez-soi-1067774.php